一般增量时间精度(DTA)指标为:

(方程1)

其中SI是取样时间间隔,单位为秒,例如20GS/s采样率下,样点时间间隔为25ps。MI是测量时间间隔,单位为秒。±0.3是示波器采集系统常系数。

采用上面的公式来定义DTA是因为几个不同因素对精度的影响不同。首先是时基精度,一个10.0MHz参考源的校准精度以及校准后是否漂移,都会影响长时间测量结果。例如,在测量一个时间为1.0ms脉冲时,低于皮秒级的影响(如内插误差)相对于0.4ppm校准偏差引起的误差非常小,因为1.0ms×0.4ppm,得到误差达到400ps。

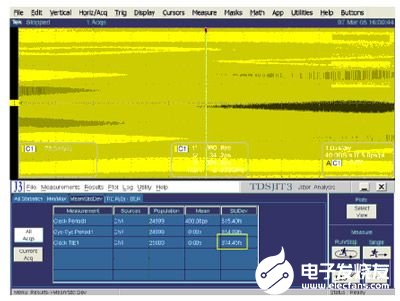

图4:采集10us稳定时钟波形得到的JNF测试结果。

通过使用TDS6804B(8GHz带宽,20GS/s采样率)进行两个时钟测量实例(一个短时钟周期、一个长时钟周期),可以查看主要误差的来源。当测试1.0GHz高速时钟时,使用TDS6804B以20GS/s实时采样率进行采样。根据DTA公式可以得到下面结果:

(方程2)

这是在单次采集或实时采集中进行的任何一项时间测量的峰峰值测量误差。在大量的样本容量(大约1,000次测量值)中,误差的标准偏差一般为0.06×SI+3.5 ppm×MI。在本例中,其约等于3.0 ps RMS(0.06×50ps+3.5ppm×1ns)。

当在测量100kHz时钟时,根据DTA公式可以得到下面结果:

(方程3)

测量误差可能会高达50ps峰值,RMS结果将受到类似的影响,因为时基误差是确定的。在这种情况下,我们看到在测量时间更长时,常数0.3决定的短期效应变得不如时基校准和稳定性对长时间结果的影响明显。在泰克示波器中,采用一种独有硬件技术保证更高的时间测试精度,称为实时内差模式,它作用在示波器采集前端,通过sinx/x内差算法在ADC的样点间插入样点,并且可以调节插入的样点数目,最小样点间隔为500fs。